H100Hopper是Nvidia的第一款具有PCIe5.0规格并支持HBM3VRAM的GPU。与前一代Ampere模型相比,该模型在FP工作负载中速度提高了6倍,并提供了更高的可扩展性。Nvidia还计划发布HopperGPU+GraceCPU超级芯片,甚至是双Grace超级芯片。

Nvidia的HopperH100AI和HPCGPU刚刚与Grace超级芯片一起在GTC上亮相。与往常一样,计算GPU模型具有高度可扩展性,Nvidia提供各种多GPU解决方案以满足不同的数据中心需求。另一方面,与2020AmpereA100型号相比,单个H100TensorCoreGPU具有显着改进,尤其是在FP运营部门。

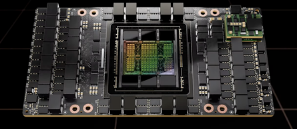

首先,H100GPU在台积电的4纳米节点上制造,芯片尺寸为814平方毫米(比A100小14平方毫米)。该型号是Nvidia首款具有PCIe5.0兼容性的型号,并且还有更快的SXM外形尺寸。GPU本身包含不少于800亿个晶体管,比Ampere增加了近50%。它还具有132个GPU集群,其中16896个CUDA核心用于SXM标准,14592个CUDA核心用于PCIe5.0标准,是上一代的两倍多。

L2缓存从40MB增加到50MB,但内存总线仍保持在5120位,内存容量设置为80GBHBM3,带宽为3或2TB/s,具体取决于外形尺寸。SXM版本有528个Tensor核心,需要700W,而PCIe版本只有456个Tensor核心,TGP限制为350W。英伟达声称20个H100GPU可以维持相当于整个世界互联网流量,但新架构可以扩展到数百甚至数千个DGX集群,这些集群将用于未来的超级计算机。

就FP性能而言,H100GPU可以处理FP8的4PFLOPS(A100的6倍)、FP16的2PFLOPS(A100的3倍)、TF32的1PFLOPS(A100的3倍)和FP64/FP32的60TFLOPS(是A100的3倍)。使用TensorCoreFP计算可以获得类似的改进。

Nvidia还计划发布GraceHopper超级芯片模块,该模块将H100GPU和GraceCPU与900GB/sNVLink连接在一起。同样,还将有一个Grace超级芯片,它结合了两个GraceCPU,提供144个ARM内核、1TB/sLPDDR5x内存带宽和396MB片上缓存。这款Grace超级芯片最多可与8个HopperGPU配对,但此类配置不会在2023年第三季度之前推出。不过,Nvidia的HopperGPU将于2022年第三季度开始出货。